文章来源:08AI导航网发布时间:2025-04-10 13:19:07

Qwen2.5-Omni 是阿里巴巴发布的Qwen 系列中的新一代端到端多模态旗舰模型。它专为全方位多模态感知设计,也就是可以理解文本、音频、图像、视频,可以同时进行思考和说话,并通过实时流式响应同时生成文本与自然语音合成输出的一个ai模型。

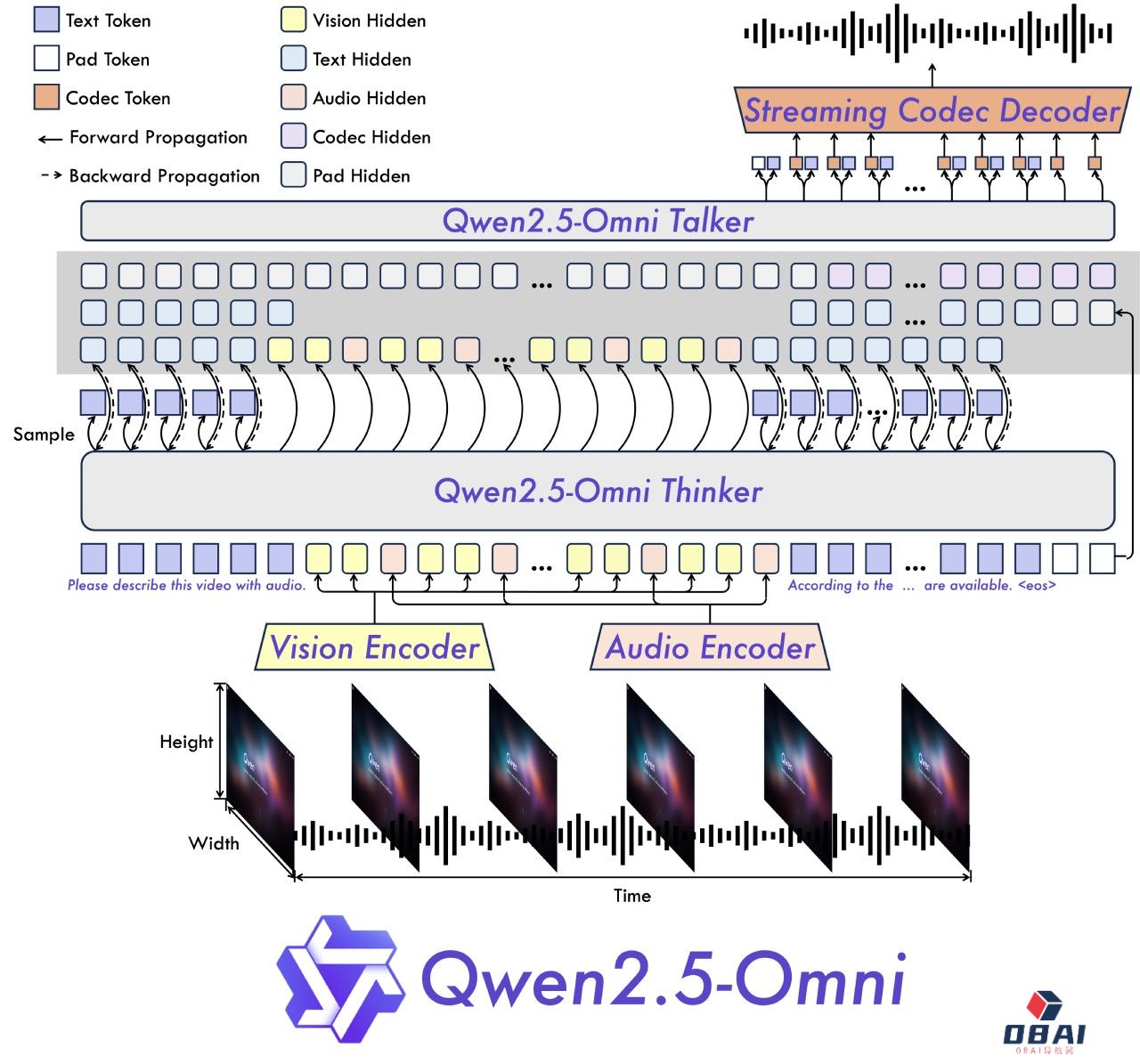

Thinker-Talker 架构:Thinker 负责处理和理解来自文本、音频和视频模态的输入,生成高级语义表征和对应的文本内容;Talker 则将这些内容转化为自然语音输出。

TMRoPE 技术:提出了一种名为 TMRoPE(Time-aligned Multimodal RoPE)的新型位置编码技术,用于同步视频输入与音频的时间戳。

支持完全实时交互,能够处理分块输入并即时输出。

在语音生成的自然性和稳定性方面超越了许多现有的流式和非流式替代方案。

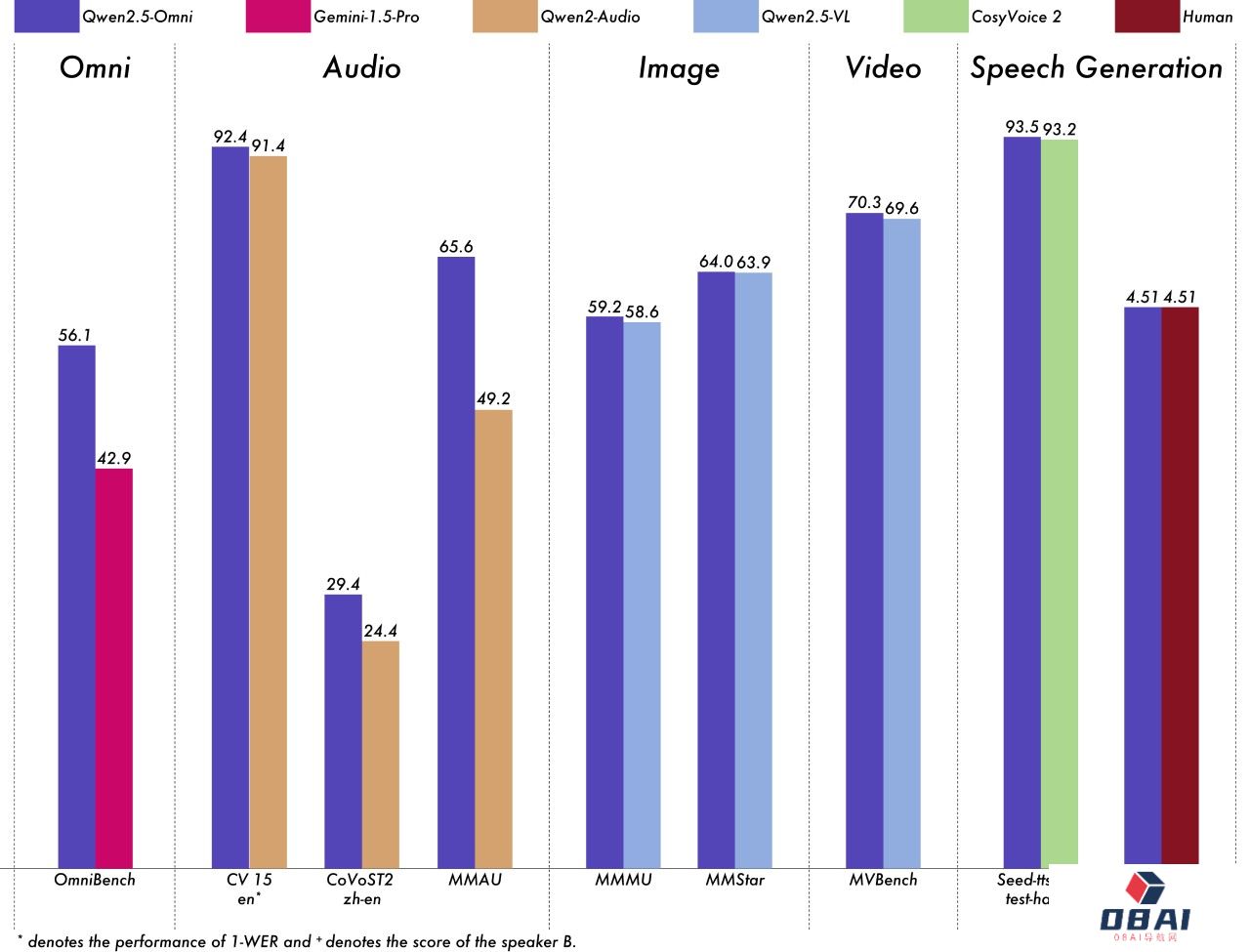

在多模态任务(如 OmniBench)中表现出色,同时在单模态任务(如语音识别、翻译、音频理解、图像推理、视频理解等)中也表现出色。

在端到端语音指令跟随方面表现出与文本输入处理相媲美的效果,在 MMLU 和 GSM8K 等基准测试中表现优异。

Thinker:类似于大脑,负责处理和理解来自文本、音频和视频模态的输入,生成高级语义表征和对应的文本内容。

Talker:类似于人类的嘴巴,接收 Thinker 生成的高级语义表征和文本内容,并以流式方式输出自然语音。

整体架构:Thinker 是一个 Transformer 解码器,配备用于音频和图像的编码器以提取信息。Talker 是一个双轨自回归 Transformer 解码器架构。在训练和推理过程中,Talker 直接接收来自 Thinker 的高维表征,并共享 Thinker 的所有历史上下文信息,整个架构作为一个统一的模型进行端到端训练和推理。

在多模态任务(如 OmniBench)中,Qwen2.5-Omni 实现了最先进的性能。

在单模态任务中,它在语音识别(Common Voice)、翻译(CoVoST2)、音频理解(MMAU)、图像推理(MMMU、MMStar)、视频理解(MVBench)和语音生成(Seed-tts-eval 和主观自然性)等方面表现出色。

Qwen Chat:https://chat.qwenlm.ai

Hugging Face:https://huggingface.co/Qwen/Qwen2.5-Omni-7B

ModelScope:https://modelscope.cn/models/Qwen/Qwen2.5-Omni-7B

DashScope:https://help.aliyun.com/zh/model-studio/user-guide/qwen-omni

GitHub:https://github.com/QwenLM/Qwen2.5-Omni

Demo体验:https://modelscope.cn/studios/Qwen/Qwen2.5-Omni-Demo

相关攻略 更多

最新资讯 更多

AI眼镜 “百镜大战” 打响!小小米眼镜官方微博上线引发市场热潮,产业链有望迎来快速发展期

更新时间:2025-04-19

新春第一课!自治区科协举办人工智能科普报告会

更新时间:2025-04-19

加速人工智能赛道布局!东莞市政府高规格召开新春第一场新闻发布会

更新时间:2025-04-19

东莞2025年“一号文”发布 聚焦“人工智能+先进制造”

更新时间:2025-04-19

马斯克:无人机和人工智能将主导未来战争 美国要加大投资

更新时间:2025-04-19

法国印度将联合主持AI行动峰会

更新时间:2025-04-19

法印将联合主持AI行动峰会,法媒:法欧希望借此峰会确立自身竞争地位

更新时间:2025-04-18

OpenAI前高管创立的AI公司据称洽谈融资 估值或达200亿美元

更新时间:2025-04-18

谷歌放弃 “不开发武器 AI” 承诺引争议,吴恩达表态支持

更新时间:2025-04-18

外交部:欢迎各国来华出席2025世界人工智能大会

更新时间:2025-04-18